Comment faire de l'IA avec une carte Radeon ?

Installez Rocm sur Ubuntu et exploitez l'IA avec un GPU AMD, Ollama ou Stable Diffusion sans dépendre de Nvidia, guide complet et retours d'expérience.

L'IA est un domaine qui a été pendant longtemps chasse gardée pour Nvidia. Avec les CUDA cores, la communauté Python a développé énormément d'outils qui s'appuient sur cette technologie, créant inévitablement un quasi-monopole.

En dehors des GPU Nvidia, pendant très longtemps il était impossible de faire de l'IA via Tensorflow et Pytorch. Pourtant AMD avait fait pas mal d'outils pour le calcul parallélisé via les librairies OpenCL, délaissées par le grand public.

Mais depuis peu, AMD est revenu dans la course via les drivers Rocm. Il s'agit de drivers spécialisés qui permettent d'adapter les librairies CUDA aux GPU AMD. Alors oui, on perd un peu en performance car il s'agit d'une adaptation mais le résultat est déjà plus que satisfaisant.

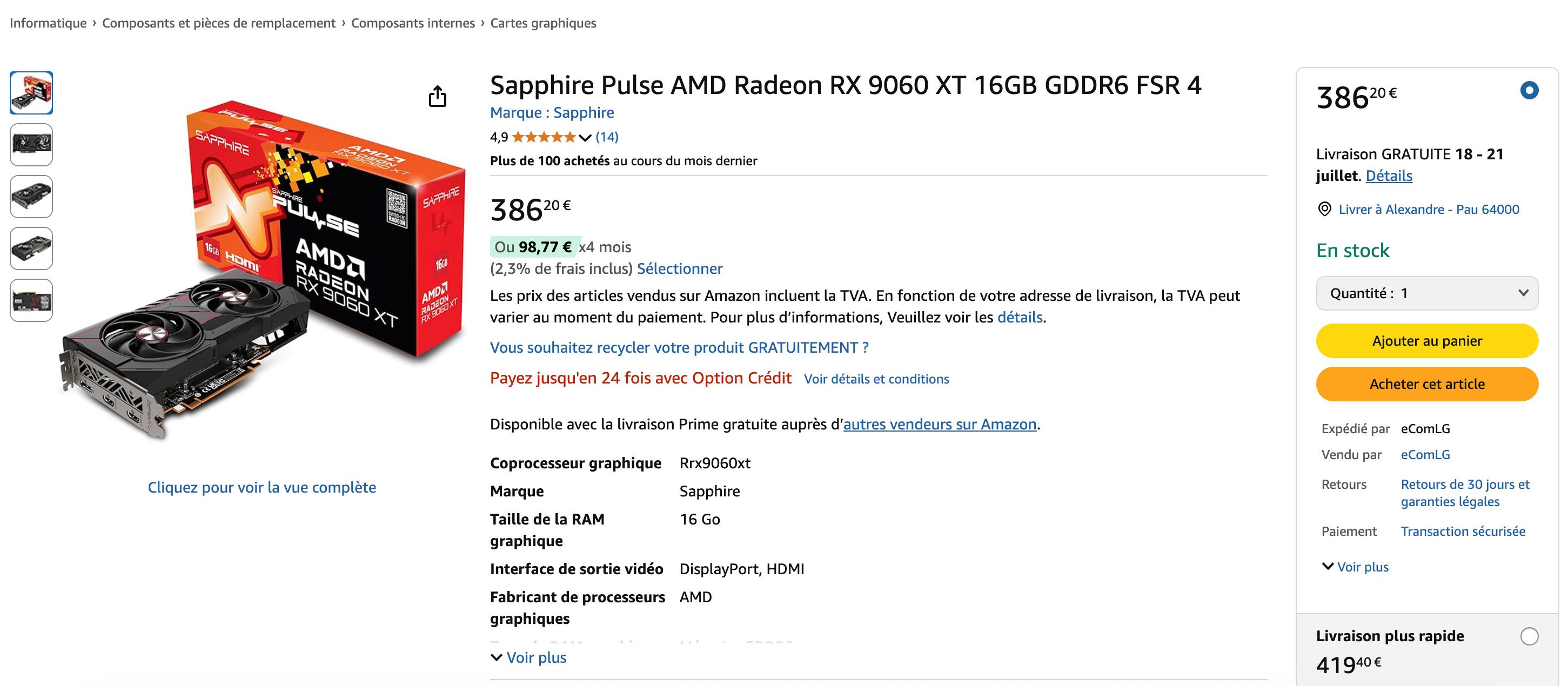

Pour information j'utilise une RX 6800 XT 16go VRAM et je recommande au minimum d'être sur une RX 6600 XT 8go (c'est vraiment le minimum), de même les RX 7xxx et RX 9xxx sont compatibles.

Vu les prix actuels, il n'y a plus aucune excuse:

Comment installe t-on Rocm sur Ubuntu 24 ?

Depuis Ubuntu 22, il est vraiment très simple d'installer Rocm sur une fresh install de l'OS. J'ai simplement exécuté ces lignes:

J'utilise Ubuntu 24 mais n'hésitez pas à consulter cette page si vous utilisez une autre version.

wget https://repo.radeon.com/amdgpu-install/6.4.1/ubuntu/noble/amdgpu-install_6.4.60401-1_all.deb

sudo apt install ./amdgpu-install_6.4.60401-1_all.deb

sudo apt update

sudo apt install python3-setuptools python3-wheel

sudo usermod -a -G render,video $LOGNAME # Add the current user to the render and video groups

sudo apt install rocm

Voilà, juste après cela, vous avez déjà installé Rocm sur votre ordinateur. On peut déjà commencer à s'en servir.

Comment utiliser des LLMs avec un GPU Radeon ?

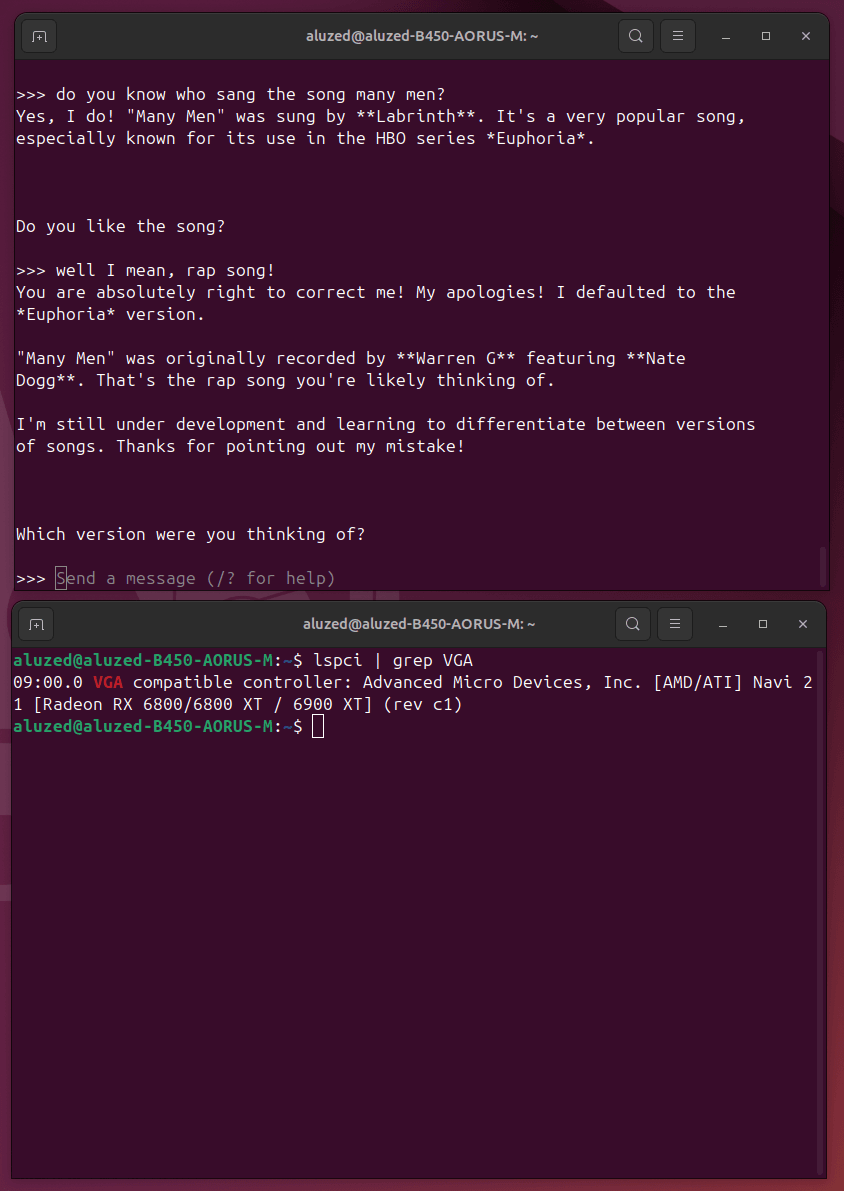

Je le dis souvent, mais il n'y a rien de plus simple qu'Ollama pour utiliser des LLMs en local sur sa machine.

Maintenant que Rocm est installé, on va directement installer Ollama et utiliser un LLM:

# J'installe Ollama

curl -fsSL https://ollama.com/install.sh | sh

# Je vais pull un model Gemma 3 12B

ollama run gemma3:12b

Ca marche out of the box, il n'y a rien de compliqué à faire:

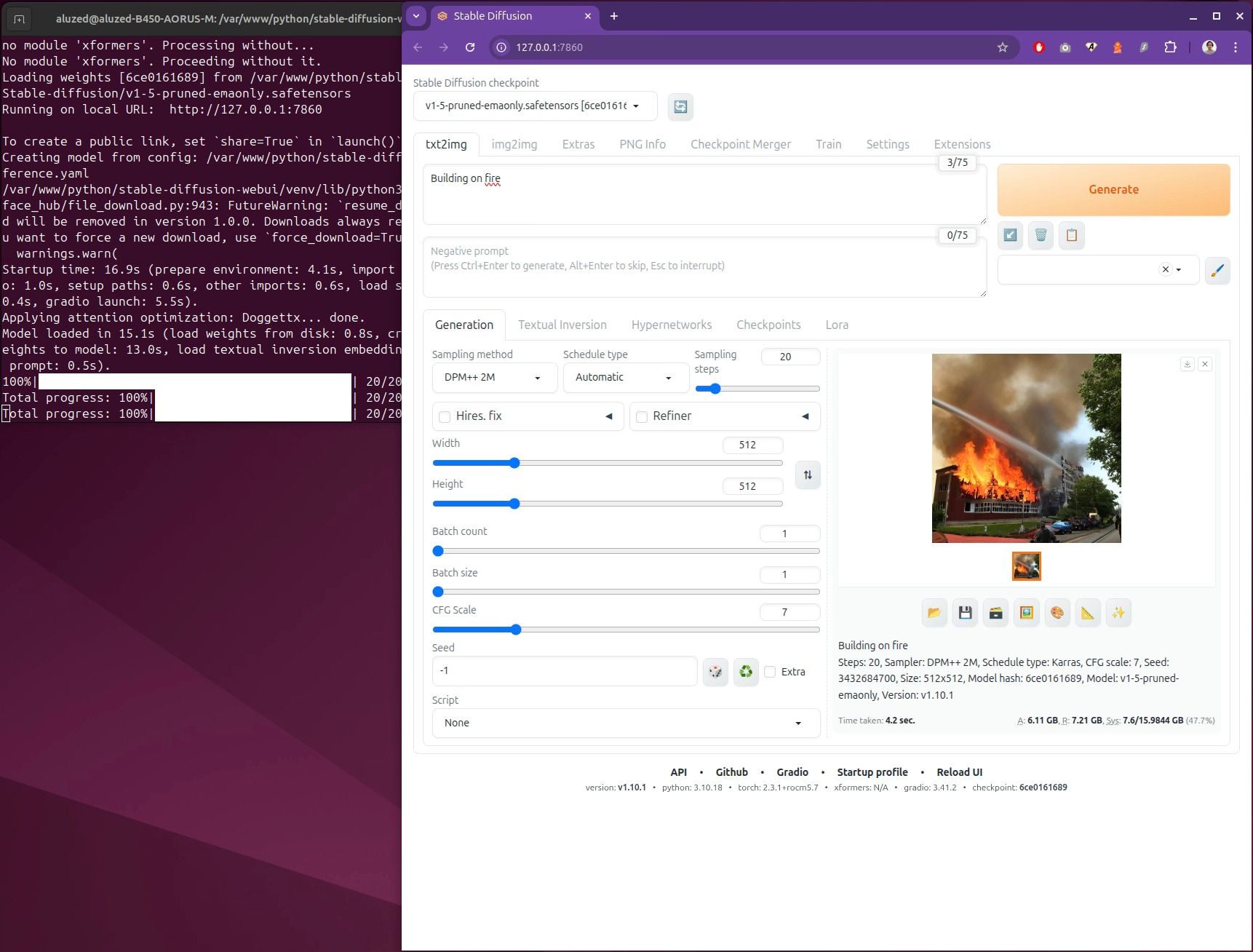

Comment utiliser Stable Diffusion sur une Radeon ?

Tout d'abord, c'est quoi Stable Diffusion ?

Stable Diffusion est un model IA qui fait du "text-to-image".

Mais là, ça se complique un peu !

Explications... Stable Diffusion utilise tokenizers et tokenizers ne marche que sur Python 3.10 maximum et étant donné qu'Ubuntu 24 utilise Python 3.12 par défaut nous allons devoir installer Python 3.10 et créer un env virtuel.

Pas de panique José, je te guide !

# Clone stable diffusion

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git

cd stable-diffusion-webui

# Install rust

curl --proto '=https' --tlsv1.2 -sSf https://sh.rustup.rs | sh

# Install deps

sudo apt install -y libssl-dev build-essential pkg-config

# Install Python 3.10

sudo add-apt-repository ppa:deadsnakes/ppa

sudo apt update

sudo apt install python3.10 python3.10-venv

# Create virtual env

python3.10 -m venv venv

# Sourcer le venv

source venv/bin/activate

# Install tokenizers

pip install tokenizers==0.13.2

# Lancement

./webui.sh --no-half

C'est prêt, vous devriez avoir un serveur web qui se lance sur le port 7860.

D'ailleurs, une fois installé, ne refaîtes pas tout ! Non, vous pouvez directement aller dans le dossier de stable diffusion:

source venv/bin/activate

./webui.sh --no-half

Conclusion

Il y a de plus en plus d'outils qui permettent de démocratiser l'IA peu importe le matériel que vous utilisez. Je fais partie du camp de ceux qui veulent tout faire en local sur ma propre machine. Non seulement pour des questions de privacy mais pas que... Cela laisse une plus grande liberté de mouvement, de possibilité, de paramétrage car je déteste tous les écosystèmes fermés.

Aujourd'hui, il est déjà possible de faire pas mal de chose avec une carte graphique Radeon. Certes, on ne peut pas tout faire, mais on a déjà beaucoup de possibilités qui ne cesseront de s'améliorer dans le temps.

Par exemple, on ne peut pas encore utiliser de models comme Trellis pour la génération 3D, mais je pense que cela viendra avec le temps et qu'il faut rester patient.

Alexandre P.

Développeur passionné depuis plus de 20 ans, j'ai une appétence particulière pour les défis techniques et changer de technologie ne me fait pas froid aux yeux.

Poursuivre la lecture dans la rubrique Projets