Comment installer et tester BitNet sur sa machine

BitNet de Microsoft : un LLM 1.58-bit ultra léger à faire tourner en local sur CPU ou GPU. Guide simple d'installation et test sur votre machine.

BitNet, c’est quoi exactement ?

BitNet, c’est une avancée majeure dans l’univers des LLMs : des modèles quantifiés en 1.58 bits, capables de tourner localement sur CPU ou GPU avec des performances surprenantes. Le tout sans sacrifier la qualité de génération.

C’est le fruit de recherches Microsoft, avec un objectif simple : rendre les LLMs plus accessibles, plus économes, et plus portables. Et contrairement à ce qu’on pourrait croire, ce n’est pas un simple proof-of-concept : BitNet permet déjà de faire tourner des modèles de plusieurs milliards de paramètres sur un laptop, sans GPU.

Quelques points clés :

- Quantification 1.58 bits = bien plus léger que les LLM 8-bit ou 4-bit.

- Compatible ARM (Mac M1/M2), x86, GPU, bientôt NPU.

- Jusqu’à 6× plus rapide, 70–80% de conso en moins.

- Basé sur les fondations de llama.cpp, mais optimisé pour le 1-bit.

Avant BitNet:

Après BitNet:

En gros, l'objectif est de faire tourner de l'IA sur des petites machines (comme un Raspberry Pi)

Et surtout : ça marche en local !

La puissance de votre machine vous apportera la vitesse d'exécution mais ne sera pas une obligation.

Installation

Je vous recommande tout de même une machine avec un peu de pêche, je suis sous Linux, mais je pense que ça marche très bien sous Windows ou Mac.

Ma config: R9 3950x, 32go ram, RTX 2080 Ti 11go

Je vous recommande d'installer Python3 d'abord, j'utilise la 3.10.

Une fois installé, nous allons utiliser un environnement virtuel pour éviter les problèmes.

# Si vous n'avez pas venv installé

sudo apt install python3-venv

python3 -m venv bitnet-env

Maintenant qu'on a notre virtual env créé dans un dossier bitnet-env, on va l'activer:

source bitnet-env/bin/activate

On va installer le reste des dépendances:

pip install torch==2.3.0 transformers==4.40.1 numpy==1.26.4 accelerate

pip install git+https://github.com/huggingface/transformers.git@096f25ae1f501a084d8ff2dcaf25fbc2bd60eba4

Exécuter BitNet en local

Sur le Hugginface de Microsoft, ils partagent BitNet avec un sample code pour que vous puissiez l'utiliser rapidement.

Je crée un fichier script.py pour importer ce sample, je le modifie légèrement pour voir s'il marche avec n'importe quelle question:

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

model_id = "microsoft/bitnet-b1.58-2B-4T"

# Load tokenizer and model

tokenizer = AutoTokenizer.from_pretrained(model_id)

model = AutoModelForCausalLM.from_pretrained(

model_id,

torch_dtype=torch.bfloat16

)

# Apply the chat template

messages = [

{"role": "system", "content": "You are a comedian AI assistant."},

{"role": "user", "content": "Can you tell me a joke?"},

]

prompt = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

chat_input = tokenizer(prompt, return_tensors="pt").to(model.device)

# Generate response

chat_outputs = model.generate(**chat_input, max_new_tokens=50)

response = tokenizer.decode(chat_outputs[0][chat_input['input_ids'].shape[-1]:], skip_special_tokens=True) # Decode only the response part

print("\nAssistant Response:", response)

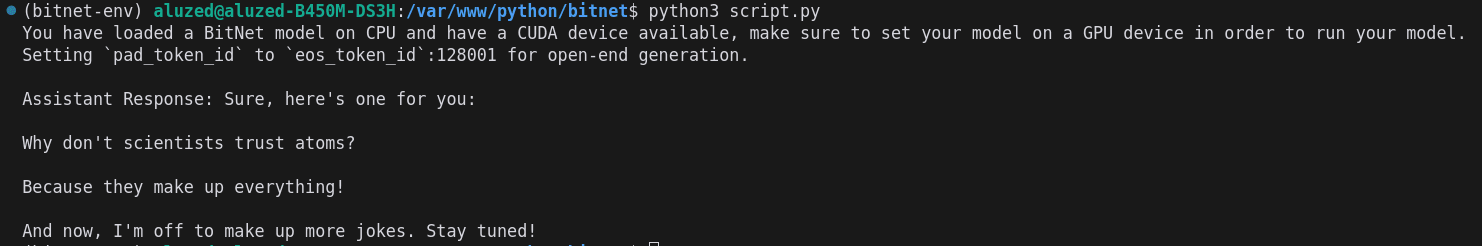

Lancement 🚀

python3 script.py

Tadaaaa 🎉:

Bon code à vous 😉

Alexandre P.

Développeur passionné depuis plus de 20 ans, j'ai une appétence particulière pour les défis techniques et changer de technologie ne me fait pas froid aux yeux.

Poursuivre la lecture dans la rubrique Dev